在此,我将向您解释如何编写一个有效的robots.txt文件,以帮助搜索引擎蜘蛛和爬虫正确地访问和索引您的网站,请注意,您的robots.txt文件应放置在网站的根目录下。

1、文件概述

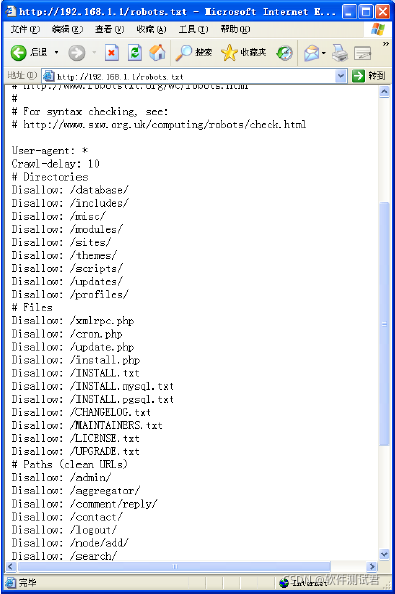

robots.txt文件用于告诉搜索引擎的爬虫如何访问您的网站,它告诉爬虫哪些页面可以抓取,哪些页面不能抓取,以及爬虫在网站上的行为等。

2、语法规则

robots.txt文件使用简单的文本格式编写,使用分号(; )来分隔不同的指令,指令通常以"User-agent"开头,后面跟着搜索引擎或爬虫的名称,然后是一个空格,再接着是"Disallow"或"Allow"指令。

"Disallow"指令指示爬虫不能访问网站中的任何页面。

"Allow"指令允许爬虫访问特定的页面。

示例:User-agent * Disallow /private/ 如果您只想让特定的页面被爬取,可以使用"Allow"指令配合URL。

3、常见指令

User-agent指定要针对哪个搜索引擎或爬虫应用该指令。

Disallow /允许所有搜索引擎或爬虫访问网站上的所有页面。

Disallow: /private/禁止爬虫访问网站的特定目录。

Allow: /content/允许爬虫访问网站的content目录及其子目录下的所有页面。

4、其他注意事项

确保您的robots.txt文件在网站的根目录下,且文件名必须为robots.txt,否则爬虫可能无法找到它。

不要使用复杂的语法或特殊字符,以免引起爬虫错误。

定期检查并更新您的robots.txt文件,以确保其始终反映您的网站结构和内容变化。

编写有效的robots.txt文件对于确保搜索引擎蜘蛛和爬虫能够正确地访问和索引您的网站至关重要,通过遵循上述指南,您可以提高网站的搜索引擎可见性和排名。